영상 기반 딥러닝을 통한 배관 진동 주파수 가시화 기술

© The Korean Society for Noise and Vibration Engineering

Abstract

Pipe systems in industries function similar to blood vessels in the human body. Pipe vibration is a natural phenomenon caused by external motors and fluid flow in the pipe. However, any unfavorable factors, such as in-wall collision by loose parts or unusual fluid flow, can significantly affect the vibration, which results in abnormal vibration patterns when compared to those during regular operation. For this reason, pipe vibration frequency is one of the important parameters to monitor in structural health monitoring. Therefore, a monitoring system that measures the vibration frequency of each pipe area helps to detect these anomalies early. In this study, a multi-kernel neural network was applied to visualize the vibration frequency of pipe areas using a multi-kernel neural network, by analyzing the characteristics of pixel-wise color variations in video data. The results showed that the vibration areas can be visualized using the color that corresponds to the frequency. The proposed model can be utilized for anomaly detection based on pipe vibration monitoring.

Keywords:

Video, Deep Learning, Pipe Vibration, Frequency, Visualization키워드:

영상, 딥러닝, 배관 진동, 주파수, 가시화1. 서 론

발전소를 비롯한 산업구조물에서 배관은 기체와 유체를 전달하는 주요 설비로서 구조적 건전성 관리를 위한 주요 모니터링 대상이다(1). 유체의 이동 및 외부 회전기계에 의한 맥동 등에 의해 배관에는 다양한 진동이 발생하며 이는 배관 설비의 운용에서 비롯되는 자연스러운 현상이다. 그러나 배관 내에 이물질이 부유하다 배관 내벽을 충격하거나 유량 및 유속이 비정상적으로 바뀌는 경우 또는 배관의 결함 및 감육, 진동 등의 원인으로 인하여 진동 양상이 바뀔 수 있다. 감육의 경우 셸 모드 주파수의 변화가 발생하고, 이물질이 배관에 충돌할 경우 충격파가 발생하며, 누설의 경우엔 주변으로 진동이 발생하고, 고진동의 경우 진동 변위가 상대적으로 크다(2). 이와 같은 비정상적인 조건에 의한 배관 진동은 정상적 조건의 배관 진동과 차이가 있다. 따라서 배관의 진동상태를 모니터링하는 시스템의 개발은 구조물 건전성 및 배관 설비의 안전을 위해 필수적이다.

배관 진동을 모니터링 하기 위해서 가속도계(3) 및 레이저 측정기(4)가 많이 활용되고 있으나, 센서 설치 및 설비 구축을 위한 현장 환경의 제약 및 대규모 배관을 모니터링하기에는 비경제적인 측면이 있다. 이를 대체하고자 카메라 영상을 활용하여 진동을 측정하는 기술들이 제안되어 왔다(5~9). 해당 기술들은 모니터링 대상에 부합하는 관심 주파수 범위 및 특징을 판별하기 위한 주파수 성분들을 전문가의 역량에 의존하여 선정해야 하며, 이를 효과적으로 추출하기 위한 영상처리 알고리즘을 개발하고 적정 조건 또한 판단하여 결정해야 하기 때문에 개발자의 경험과 전문성에 의존하게 된다. Optical flow(10,11) 및 kanade-lucas-tomasi(12,13) 활용한 경우엔 픽셀의 2차원 변화율을 추출하고 특징점을 추적하는 과정과 픽셀별 변화율을 활용해 진동 특성을 분석하는 후처리가 수반되어야 한다. 다양한 조건에 대한 보다 강건한 모니터링 환경을 갖추기 위해서는 영상 기반의 진동 측정을 위한 알고리즘 개발의 지능화가 필요하다.

딥러닝(deep learning) 기술 중의 하나인 합성곱 신경망(convolutional neural network: CNN)은 특히 영상 분석 분야에서 매우 우수한 성능을 입증하였다(14). 최근 CNN과 attention을 활용한 CoAtNet(15) 모델이 1000 가지 범주로부터 약 1400만 장의 이미지를 선정하여 만든 ImageNet(16) 데이터셋에서 90.88 %의 Top-1 accuracy를 달성했다. 합성곱 신경망의 각 커널(kernel)은 이미지의 특징들을 학습하고, 여러 개의 커널들이 계층적으로 쌓여 심층 신경망(deep neural network)이 된다. 이미지 분석을 위한 신경망에서는 각각의 계층(layer)은 일반적으로 같은 크기의 복수의 커널로 구성되지만, 다양한 크기의 다중 커널(multiple kernel)을 활용한다면 모델 성능이 더욱 향상될 수 있다(17,18). 진동 주파수 추정을 위해 2차원 이미지를 입력으로 하는 CNN-LSTM(19) 및 이를 시간영역에서 쌓은 3차원 데이터를 입력으로 한 3DCNN-ConvLSTM(20) 같은 모델이 제안되었으나, 진동체의 크기와 형태의 변화에 영향을 크게 받는다. 이를 보완할 수 있는 각 픽셀의 색상 변화를 1차원 시계열 데이터로 입력하는 CNN(21,22)도 있으나, 진동체의 대표 주파수 추정에 초점이 맞춰져 있어서 픽셀별 진동을 세밀하게 추정하는 개선이 필요하다.

이 연구에서는 다중 커널 심층 신경망을 활용하여 카메라를 통해 촬영된 영상 데이터로부터 각 픽셀 (pixel)의 색상 변화 특성을 심층 신경망의 입력으로 하여 해당 픽셀의 진동 주파수로 출력함으로써 영상 내에 진동하는 영역의 진동 주파수를 가시화하는 기술을 소개한다. 이를 통해 배관의 진동부의 진동 주파수 특성을 다중 커널 합성곱 신경망 기반의 딥러닝으로 가시화할 수 있음을 보이고, 이러한 접근법은 배관 진동의 정상과 비정상을 판단하는 이상탐지 모델에 응용할 수 있을 것으로 기대한다.

2. 배관 진동 영상 촬영 및 데이터셋 구축

2.1 배관 진동 영상 촬영

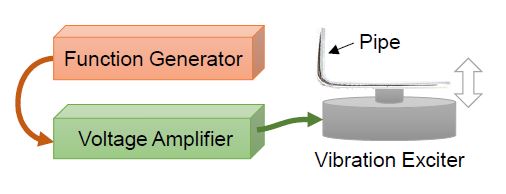

모의 진동을 위한 장치를 Fig. 1과 같이 구성했다. 함수발생기(function generator)를 통해서 원하는 진동 주파수의 파형을 생성하고, 이는 전압 증폭기(voltage amplifier)를 통해 증폭되어 가진기(vibration exciter)에 전달된다. 가진기는 함수발생기에 설정된 주파수에 해당하는 주기로 상하 진동을 하며, 배관 진동을 모사하기 위해 가진기 상단에 SUS304 소재의 L자형 배관(외경: 9.53 mm, 내경: 7.75 mm, 두께: 0.89 mm, 긴 축 길이: 32 cm, 짧은 축 길이: 15 cm)을 부착하였다.

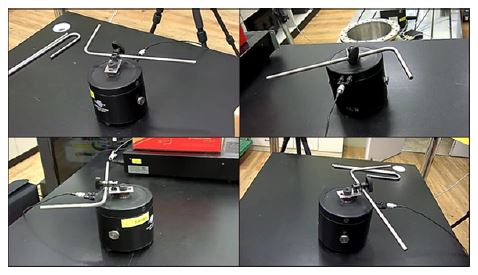

배관 진동을 모니터링 하기 위해 Fig. 2와 같이 다양한 각도에서 가진기와 배관을 향해 4대의 카메라를 활용하여 배관의 진동 상태를 영상으로 기록했다. 각 카메라를 통해 빨간색, 녹색, 청색의 세 개의 채널(red, green, blue: RGB)로 영상이 수집되며, 가로 640 픽셀, 세로 480 픽셀 크기의 프레임(frame)으로 초당 60장씩(60 frame per second) 기록되었다. 각 프레임은 약 30만 개의 픽셀이 있다.

배관 진동은 1 Hz에서 30 Hz까지 1 Hz 간격으로 변경하며 진동을 가하였다. 4대의 카메라이므로 총 120가지의 조건에 대해서 각 평균 18.5초 진동 배관의 영상을 수집했고, 따라서 총 수집된 프레임 개수는 약 13만 장이다.

2.2 픽셀별 진동 주파수 데이터셋 구축

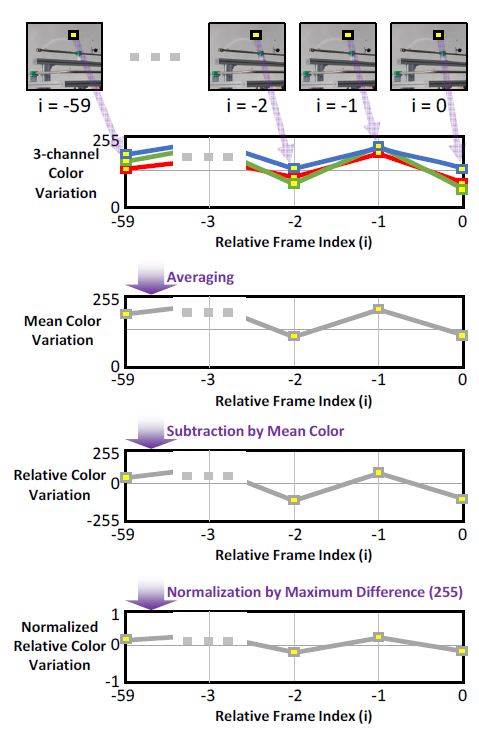

픽셀의 진동을 분석하기 위해서 1초(60 frame)에 해당되는 각 픽셀의 색상 변화를 시계열 신호처럼 시퀀스(sequence)로 간주하여 다루었다. Fig. 3과 같은 절차를 통해, 각 시퀀스의 RGB 세 채널의 변화가 유사한 점을 고려하여 세 채널의 평균값을 취하여 60 개의 색상 값을 가지는 하나의 시계열 데이터로 만든 후, 해당 단일 색상 시퀀스의 평균 값을 빼어 시퀀스의 평균이 0이 되도록 하고, 색상 범위의 최대값인 255로 나누어 –1에서 1 사이의 값을 나타내도록 정규화 했다. 이러한 전처리를 통해, 각 픽셀의 상대적 색상 변화를 단일 시퀀스로 추출하여 진동과 관련이 없는 조명 변화 및 다양한 배관 색상 등에 따른 색상 특성이 배제될 수 있도록 하였다.

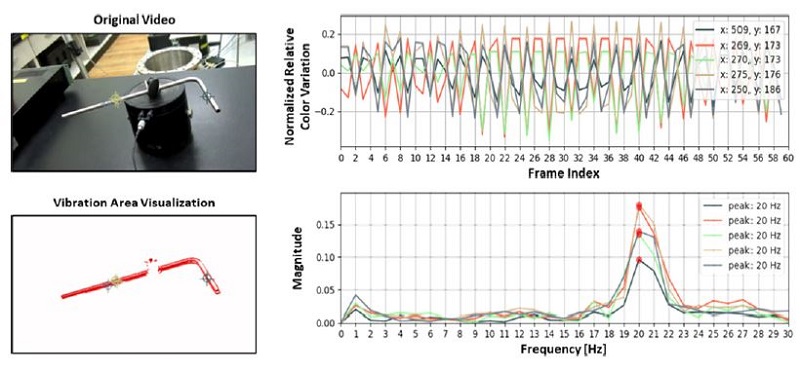

영상 데이터를 수집할 때 진동 주파수가 사전에 설정이 되었고, 입력 영상에 대해 앞서 서술한 픽셀 단위의 색상 변화 데이터 전처리 기법을 적용한 결과를 Fig. 4에 예시로 나타냈다. 진동 영역 가시화(vibration area visualization)는 데이터 전처리 후의 정규화 된 상대 단일 색상 변화(normalized relative color variation)가 0.1 이상인 픽셀만 붉은색으로 나타내고 나머진 흰색으로 나타낸 결과이다. 붉은색 픽셀 중 임의의 다섯 개의 위치에 대해서 데이터 전처리가 이뤄진 해당 시퀀스에 대한 주파수 분석결과가 진동 주파수와 동일함을 확인하였다. 이를 근거로 각 영상에서의 진동 영역에 해당하는 픽셀은 가진기의 진동 주파수로 진동하고 있는 것으로 레이블링(labeling)을 하였다. 진동하지 않은 픽셀들에 대해서는 0 Hz로 레이블링하였다.

학습(train)과 검증(validation), 평가(test) 데이터셋을 구축하기 위해 Table 1과 같이 70:15:15의 비율로 시퀀스 개수는 임의 샘플링을 하였고, 이때 각 데이터셋 별로 0 Hz에서 30 Hz까지의 각 주파수에 해당하는 데이터의 비율이 서로 동일하도록 계층적 임의 샘플링(stratified random sampling)하여 클래스 불균형(class imbalance) 문제가 없도록 하였다. 또한, 학습 데이터셋은 카메라 위치 2곳, 검증과 평가 데이터셋은 각각 나머지 다른 카메라 위치 2곳에서 샘플링을 수행하여, 학습, 검증, 평가 데이터셋은 모두 서로 다른 카메라 위치에서 수집된 영상으로써 검증과 평가 데이터셋이 학습에 포함되지 않도록 하여 객관적인 성능평가가 이뤄질 수 있도록 하였다.

3. 진동 주파수 추정을 위한 딥러닝

3.1 다중 커널 합성곱 신경망 구성

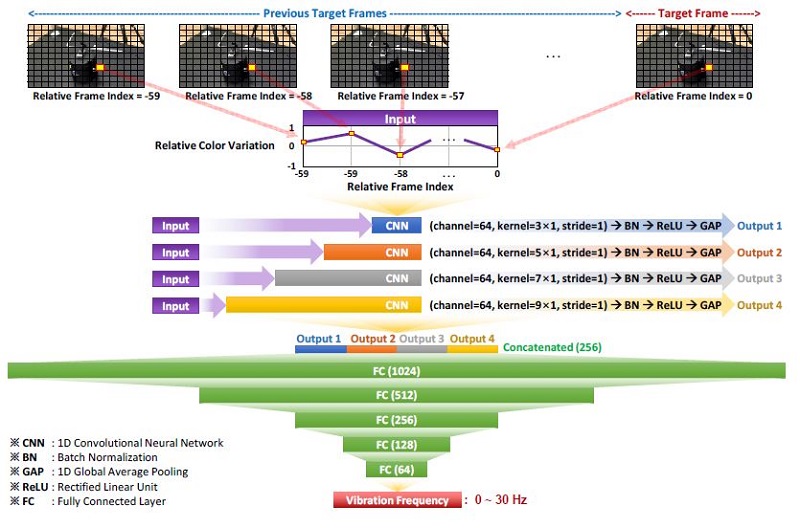

각 픽셀의 정규화된 상대 단일 색상 변화에 해당하는 60개의 값으로 이뤄진 시퀀스를 입력으로 하고 진동 주파수에 대한 추정값을 출력하기 위해 다중 커널 합성곱 신경망(multi-kernel convolutional neural network)을 Fig. 5와 같이 구성하였다. 60 프레임의 입력 데이터의 크기는 60×1이며, 시간영역에서 저주파와 고주파 특성을 각각 독립적으로 고려하여 색상 변화의 특징을 학습하기 위해 네 가지 종류의 크기(3×1, 5×1, 7×1, 9×1)를 가진 커널을 각 64개씩 활용했다. 모델의 입력 데이터는 동일하게 각 커널을 통과하며, batch normalization, global average pooling을 거쳐서 각각 64×1의 크기를 가진 특징 벡터로 출력된다. 활성함수는 학습 효율 좋고 back propagation이 유리한 ReLU를 활용하였다. 이렇게 나온 특징 벡터들을 256×1 형태로 재배열한 후, 다섯 개(1024, 512, 256, 128, 64)의 완전 연결 계층(fully connected layer: FC)을 통과시켜, 최종적으로 진동 주파수로 추정하는 값을 출력하도록 하였다. 이 모델의 총 학습 파라미터는 약 96만 개이며, TensorFlow 2.5를 활용하여 구현하였다.

3.2 학습 조건 및 결과

진동 주파수의 오차에 해당하는 평균 절대 오차(mean absolute error: MAE)를 손실함수로 했으며, 최적화 기법(optimizer)으로는 모델의 가중치 갱신에 관성(momentum) 및 평균 제곱근 전파(root mean square propagation: RMSProp)를 고려한 Adam (adaptive moment estimation)을 채택했다. 관성은 파라미터가 갱신되는 방향성을 안정화하여 학습을 고속화하고, 또한 평균 제곱근 전파는 지수 가중 이동평균법(exponential weighted moving average)을 적용하여 파라미터 갱신이 상대적으로 적었던 파라미터들의 학습을 촉진하여 학습 성능과 효율을 향상시키는 효과가 있다.

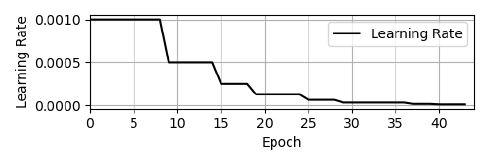

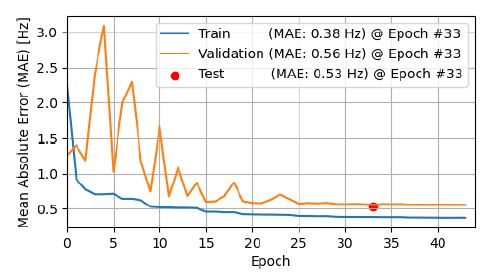

데이터셋의 배치 크기는 64로 통일하였고, 최초 학습률(learning rate)은 0.001로 설정하였으며 Fig. 6과 같이 매 횟수(epoch)의 학습 및 검증 과정에서 MAE가 3회 이상의 epoch가 지나도 최소 MAE가 갱신되지 않으면 학습률을 50 %씩 감소시켰고 epoch가 10회 지나도 갱신되지 않으면 학습을 조기 종료(early stopping)하여 과적합을 방지하였다. MAE 변화는 Fig. 7과 같이 epoch에 따라 줄어들며 학습이 잘 이뤄짐이 확인되었으며, 검증 데이터셋에 대한 MAE 최소값인 0.56 Hz 가진 33번째 epoch에서 평가 데이터셋의 MAE는 0.53 Hz로 나타났다.

4. 진동 주파수 가시화 결과 및 성능 분석

4.1 학습된 모델을 활용한 진동 주파수 가시화

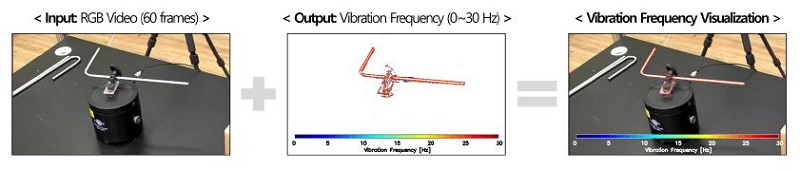

검증 데이터셋의 MAE가 최소값을 나타낸 모델을 활용하여, 진동 영상의 전체 픽셀에 대해서 진동 주파수를 추정한 출력 영상을 Fig. 8과 같이 합성(overlay)하여 영상 데이터 내의 진동 영역 및 진동 주파수를 가시화하였다. 입력 영상에서 매 60 프레임씩 추출하여 각 픽셀 별로 모델 학습을 위해 수행한 데이터 전처리를 적용 후 모델에 입력하였고, 모델에서 출력된 각 픽셀의 진동 주파수 값을 입력 영상의 크기로 재배치한 후 진동 주파수에 따라 할당된 색상으로 각 치환하여 진동 주파수 이미지를 생성했다. 생성된 영상과 입력 영상을 합성하면 진동 영역이 진동 주파수에 상응한 색상으로 가시화된다. NVIDIA GeForce RTX 3090의 활용하는 경우, 60 프레임 영상(가로: 640 픽셀, 세로: 480 픽셀, 총 약 30만 픽셀)의 진동 주파수를 판독하는 데에 약 100 ms (9.5 frame per second)가 소요되었다.

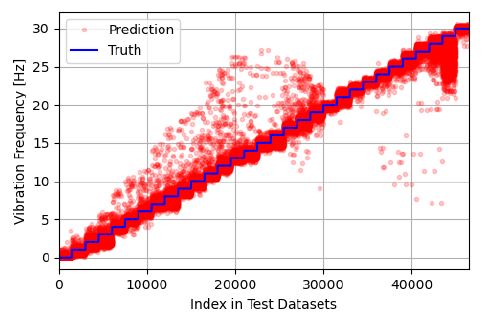

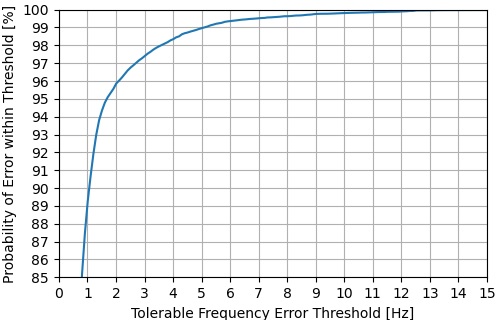

4.2 진동 주파수 추정 오차 및 성능 분석

평가 데이터셋에 대해서 실제 진동 주파수와 모델이 추정한 진동 주파수를 Fig. 9에 도식화했다. 성능을 정량적으로 분석하기 위해서 Fig. 10과 같이 용인 가능한 주파수 오차 임계값(tolerable frequency error threshold [Hz]) 이내에 들어오는 데이터의 비율(probability of error within threshold [%])을 산출하였다. 평가 데이터셋에 대해서 모델의 진동 주파수 추정 오차가 1 Hz 이내일 확률은 89.25 %이며, 5 Hz 이내일 확률은 98.96 %이다. 용인되는 임계값이 커질수록 해당 임계값 범위 내에 오차가 속할 확률(probability)이 높아지는 특징이 확인된다. 진동 주파수성분이 가시화된 영상의 약 90 %에 해당하는 픽셀들이 1 Hz 이내의 오차를 나타낼 것으로 기대할 수 있기 때문에, 나머지 10 % 영역이 다소 부정확한 주파수를 나타냄을 고려하더라도 해당 진동 영역에 대한 주요한 진동 특성을 파악하는데 제안된 모델이 유효하며 이를 응용해 진동에 따른 이상탐지 및 상황 판단 등에 적용도 가능하다. 이 연구에서는 단일 배관의 진동을 대상으로 영상을 수집하였으나 다양한 배관 설비 구성 및 진동 조건에 대한 학습 데이터셋의 확보 및 모델의 하이퍼파라미터 튜닝을 통해 주파수 추정 정확도가 향상될 수 있고, 시간 분해능이 더 높은 초고속 카메라를 활용하여 영상을 수집하면 정밀한 주파수 분해능을 기대할 수 있다. 또한, 제안 모델은 각 픽셀의 색상 변화만을 다루기 때문에 단순 알고리즘으로 영상을 고속으로 처리할 수 있는 장점이 있으며, optical flow 및 kanade-lucas-tomasi 기법을 적용한 데이터를 모델의 입력으로 활용한다면 데이터 전처리 처리속도는 느려지더라도 더 높은 정확도의 주파수 추정이 가능할 수 있다.

5. 결 론

이 연구에서는 영상 데이터 내의 진동 영역 및 진동 주파수를 가시화하는 기술을 개발하였다. 진동 주파수 추정을 위해 다중 커널 합성곱 신경망을 활용해 픽셀의 색상 변화 특성에 학습하였고, 학습된 모델을 통해 각 픽셀의 진동 주파수를 추정하였다. 진동 주파수를 추정한 출력 영상을 입력 영상과 합성하여 진동 영역 및 진동 주파수를 가시화했다. 평가 데이터셋에 대해 진동 주파수 추정 오차가 1 Hz 이내일 확률은 89.25 %였고, 5 Hz 이내일 확률은 98.96 %로 나타났다. 이는 다중 커널 합성곱 신경망 기반의 딥러닝을 통해 영상 데이터의 진동 주파수 특성을 효과적으로 가시화할 수 있고, 진동상태의 이상탐지에 활용될 수 있을 것임을 보여준다.

Acknowledgments

이 성과는 2020년도 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(No. NRF-2020M2C9A1062710).

References

-

Park, J. H., Yoon, D. B., Lee, J. H. and Choi, Y. C., 2019, Condition Monitoring and Diagnosis in Mechanical Components of Nuclear Power Plan, Journal of the Korean Society for Nondestructive Testing, Vol. 39, No. 6, pp. 369~377.

[https://doi.org/10.7779/JKSNT.2019.39.6.369]

-

Park, S.-J., Chung, B.-Y., Park, J.-H. and Choi, Y.-C., 2021, Analysis of Vibration Characteristics of Secondary Piping Faults in Testbed, Research, and Commercial Reactors, Transactions of the Korean Society for Noise and Vibration Engineering, Vol. 31, No. 6, pp. 675~683.

[https://doi.org/10.5050/KSNVE.2021.31.6.675]

-

Suh, J. S., 2014, A Study on the Measurement of the Pipeline Displacement Vibration Using Accelerometers, Transactions of the Korean Society for Noise and Vibration Engineering, Vol. 24, No. 6, pp. 476~482.

[https://doi.org/10.5050/KSNVE.2014.24.6.476]

- Lee, C.-B., Ahn, S.-H., Yang, S.-H., Yum, J.-W., Kang, D.-W. and Kim, K.-D., 2004, Vibration Measurements of Large-scale Structure Using Laser and High-speed CCD Camera, The Journal of Korean Institute of Communications and Information Sciences, Vol. 29, No. 8, pp. 1104~1112.

-

Jeon, H.-S., Choi, Y.-C., Park, J.-H. and Park, J. W., 2010, Parameter Studies for Measuring Vibration by Using Camera, Transactions of the Korean Society for Noise and Vibration Engineering, Vol. 20, No. 11, pp. 1033~1037.

[https://doi.org/10.5050/KSNVE.2010.20.11.1033]

-

Jeon, H. S., Choi, Y. C. and Park, J. W., 2009, Measurement Structural Vibration from Video Signal Using Curve Fitting, Transactions of the Korean Society for Noise and Vibration Engineering, Vol. 19, No. 9, pp. 943~949.

[https://doi.org/10.5050/KSNVN.2009.19.9.943]

-

Jeon, H. S., Choi, Y. C. and Park, J. W., 2008, Displacement Measurement of Multi-Point Using a Pattern Recognition from Video Signal, Transactions of the Korean Society for Noise and Vibration Engineering, Vol. 18, No. 12, pp. 1256~1261.

[https://doi.org/10.5050/KSNVN.2008.18.12.1256]

-

Kim, K. Y. and Kwak, M. K., 2005, Measurement of Large-amplitude and Low-frequency Vibrations of Structures Using the Image Processing Method, Transactions of the Korean Society for Noise and Vibration Engineering, Vol. 15, No. 3, pp. 329~333.

[https://doi.org/10.5050/KSNVN.2005.15.3.329]

-

Kim, S. O., Park, J. S. and Park, J. W., 2019, A Leak Detection and 3D Source Localization Method on a Plant Piping System by Using Multiple Cameras, Nuclear Engineering and Technology, Vol. 51, No. 1, pp. 155~162.

[https://doi.org/10.1016/j.net.2018.09.012]

-

Lee, K., Na, J., Sohn, J., Sohn, S. and Lee, S., 2020, Image Recognition Algorithm for Maintenance Data Digitization: CNN and FCN, Transactions of the Korean Society for Noise and Vibration Engineering, Vol. 30, No. 2, pp. 136~142.

[https://doi.org/10.5050/KSNVE.2020.30.2.136]

-

Yu, Q., Yin, A., Zhang, Q. and Ma, S., 2017, Optical Flow Tracking Method for Vibration Identification of Out-of-plane Vision, Journal of Vibroengineering, Vol. 19, No. 4, pp. 2363~2374.

[https://doi.org/10.21595/jve.2017.17771]

-

Diamond, D. H., Heyns, P. S. and Oberholster, A. J., 2017, Accuracy Evaluation of Sub-pixel Structural Vibration Measurements through Optical Flow Analysis of a Video Sequence, Measurement, Vol. 95, pp. 166~172.

[https://doi.org/10.1016/j.measurement.2016.10.021]

-

Won, D. H., Sung, S. and Lee, Y. J., 2012, Particle Filter Based Feature Points Tracking for Vision Based Navigation System, Journal of the Korean Society Aeronautical and Space Sciences, Vol. 40, No. 1, pp. 35~42.

[https://doi.org/10.5139/JKSAS.2012.40.1.35]

-

Morlier, J. and Michon, G., 2010, Virtual Vibration Measurement Using KLT Motion Tracking Algorithm, Journal of Dynamic Systems, Measurement, and Control, Vol. 132, No. 1, 011003.

[https://doi.org/10.1115/1.4000070]

- Dai, Z., Liu, H., Le, Q. and Tan, M., 2021, CoatNet: Marrying Convolution and Attention for All Data Sizes, Advances in Neural Information Processing Systems, 34.

-

Deng, J., Dong, W., Socher, R., Li, L. J., Li, K. and Li, F.-F., 2009, ImageNet: A Large-scale Hierarchical Image Database, Proceedings of 2009 IEEE Conference on Computer Vision and Pattern Recognition, pp. 248~255.

[https://doi.org/10.1109/CVPR.2009.5206848]

-

Seo, H., Jeong, B., Jun, J. and Choi, Y.-C., 2021, Video-based Deep Learning for Pipe Leakage Visualization, Transactions of the Korean Society for Noise and Vibration Engineering, Vol. 31, No. 5, pp. 521~528.

[https://doi.org/10.5050/KSNVE.2021.31.5.521]

-

Sohn, W. B., Lee, S. Y. and Kim, S., 2020, Single-layer Multiple-kernel-based Convolutional Neural Network for Biological Raman Spectral Analysis, Journal of Raman Spectroscopy, Vol. 51, No. 3, pp. 414~421.

[https://doi.org/10.1002/jrs.5804]

-

Yang, R., Singh, S. K., Tavakkoli, M., Amiri, N., Yang, Y., Karami, M. A. and Rai, R., 2020, CNN-LSTM Deep Learning Architecture for Computer Vision-based Modal Frequency Detection, Mechanical Systems and Signal Processing, Vol. 144, 106885.

[https://doi.org/10.1016/j.ymssp.2020.106885]

-

Alimasi, A., Liu, H. and Lyu, C., 2020, Low Frequency Vibration Visual Monitoring System Based on Multi-modal 3DCNN-convLSTM, Sensors, Vol. 20, No. 20, p. 5872.

[https://doi.org/10.3390/s20205872]

-

Liu, J. and Yang, X., 2019, Artificial Neural Network for Vibration Frequency Measurement Using Kinect V2, Shock and Vibration, 9064830.

[https://doi.org/10.1155/2019/9064830]

-

Liu, J. and Yang, X., 2018, Learning to See the Vibration: A Neural Network for Vibration Frequency Prediction, Sensors, Vol. 18, No. 8, p. 2530.

[https://doi.org/10.3390/s18082530]

Hogeon Seo received the B.S. degree in Mechanical Engineering and the Ph.D. degree in Convergence Mechanical Engineering from Hanyang University in 2013 and 2018, respectively. He is currently a senior researcher in Artificial Intelligence Application & Strategy Team of Korea Atomic Energy Research Institute. His research interests include artificial intelligence for prognosis, nondestructive evaluation, and sensor fusion.

Young-Chul Choi received B.S. from Pusan National University in 1998. He then received his M.S and Ph.D. degree from KAIST in 2000 and 2005 respectively. Dr. Choi is currently a principal researcher at Korea Atomic Research Institute.